重复数据筛选(如何高效)

在大数据时代,数据分析已成为企业决策的重要依据,然而,数据中常常存在大量的重复数据,这些重复数据不仅会浪费存储空间和计算资源,还会影响数据分析的准确性和可靠性。筛选重复数据成为优化数据分析过程的关键步骤。

一、为何重复数据对数据分析产生负面影响?

重复数据会使得数据集的大小大大增加,占用了宝贵的存储空间,并且会增加计算资源的消耗。在进行数据分析时,重复数据会导致结果的偏差和误导,降低分析的准确性和可靠性。

二、基于唯一标识的筛选方法

通过识别唯一标识,如ID或关键字段,可以根据这些标识进行去重操作。这种方法简单直接,但在存在多个唯一标识或标识不完全匹配的情况下可能存在问题。

三、使用排序算法进行重复数据检测

排序算法可将重复数据放在相邻位置,从而便于识别和删除。常用的排序算法有冒泡排序、快速排序和归并排序等,根据实际情况选择适合的算法进行重复数据检测。

四、基于哈希算法的重复数据筛选

哈希算法可以将数据映射为唯一的哈希值,通过比较哈希值来判断数据是否重复。常见的哈希算法有MD5、SHA-1和CRC32等,选择合适的哈希算法可以高效地筛选重复数据。

五、利用数据库工具进行重复数据去除

数据库工具提供了方便快捷的重复数据去除功能,可以根据字段或条件进行去重操作。通过使用数据库工具,可以快速高效地处理大规模的数据集,提升数据分析的效率。

六、使用数据清洗工具进行重复数据处理

数据清洗工具可以自动识别和删除重复数据,同时还可以进行其他数据质量相关的操作,如缺失值处理和异常值检测等。选择适合的数据清洗工具可以减轻数据分析人员的工作负担。

七、避免数据源重复导入

在数据分析过程中,避免将相同的数据源重复导入是非常重要的。及时清理和整理数据源,确保数据源的唯一性,可以避免后续分析中的重复数据问题。

八、建立合理的数据标准化规则

通过建立合理的数据标准化规则,将不同格式和表示方式的重复数据进行整合和统一。这样可以减少重复数据的数量,提高数据分析的准确性。

九、人工复核和验证重复数据

尽管现代技术可以帮助我们高效地筛选重复数据,但人工复核和验证仍然是必要的。通过人工的目视和对比,可以进一步确保数据的准确性和可信度。

十、定期维护数据清洁度

数据清洁度是保证数据分析质量的关键因素,定期维护数据清洁度可以帮助及时发现和处理重复数据,并保证分析结果的准确性。

十一、重复数据筛选的挑战与解决方案

重复数据筛选过程中会面临多种挑战,如大数据量、多个唯一标识和复杂的数据结构等。针对这些挑战,我们可以采用增量处理、并行计算和算法优化等方式来提升筛选效果。

十二、重复数据筛选对数据分析的意义

有效地筛选重复数据不仅可以提升数据分析的效率和准确性,还可以为后续的模型建立、预测和决策提供更可靠的数据基础,从而提升企业的竞争力和盈利能力。

十三、和展望

重复数据筛选作为优化数据分析的关键步骤,对于保证数据质量和提升分析效果具有重要意义。未来,随着数据规模和复杂度的不断增加,我们需要不断改进和创新筛选方法,以适应新的数据分析需求。

通过本文的介绍,我们了解了重复数据对数据分析的负面影响,并提出了一系列筛选重复数据的方法和技巧。在实际操作中,我们应根据具体情况选择合适的筛选方法,并注意定期维护数据清洁度,以提高数据分析的准确性和可靠性。重复数据筛选是优化数据分析的关键步骤,只有将数据中的重复信息剔除,才能更好地挖掘数据的价值,为企业决策提供有力支持。

如何高效筛选重复数据

在当今信息爆炸的时代,我们每天都要处理大量的数据。然而,由于种种原因,我们常常会遭遇数据重复的问题,这不仅浪费了我们的时间和精力,还可能导致信息混乱和决策错误。本文将介绍一些高效筛选重复数据的方法和技巧,帮助您有效减少工作中的数据冗余与重复。

段落

1.使用数据分析工具进行初步筛选

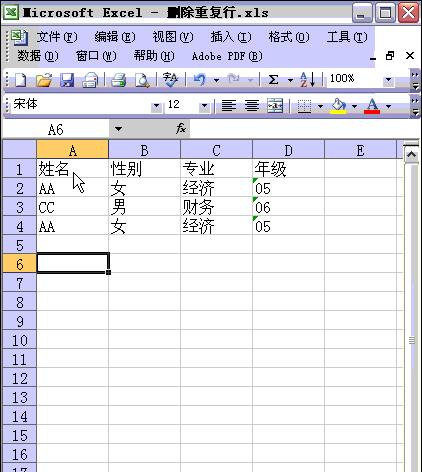

使用强大的数据分析工具,如Excel、Pythonpandas等,可以帮助您快速找出可能存在的重复数据,并对其进行初步筛选和处理。

2.比对数据字段进行精确匹配

对于关键字段相同但其他字段不同的数据,可以通过比对关键字段进行精确匹配,将重复数据筛选出来。

3.利用模糊匹配技术识别相似数据

有些情况下,数据之间存在微小差异,但实际上是相似的。利用模糊匹配技术,如Levenshtein距离算法等,可以帮助我们识别这些相似数据并进行筛选。

4.建立数据索引和唯一标识

建立数据索引和唯一标识是一种常见的筛选重复数据的方法。通过为数据设置唯一标识,我们可以快速识别出重复数据,并进行后续处理。

5.制定严格的数据录入规范

数据录入规范对于减少数据冗余和重复非常重要。制定严格的数据录入规范,包括字段命名规则、数据格式要求等,可以有效避免重复数据的产生。

6.利用数据去重工具进行筛选

数据去重工具是一种高效筛选重复数据的辅助工具。通过使用这些工具,我们可以快速、准确地去除数据中的重复项。

7.定期清理和更新数据

定期清理和更新数据是保持数据质量的关键步骤。通过定期检查和清理数据,我们可以及时发现并解决重复数据的问题,保持数据的准确性和完整性。

8.进行数据分析和可视化

通过对数据进行分析和可视化,我们可以更加清晰地了解数据之间的关系和特征,从而发现可能存在的重复数据,并进行进一步筛选。

9.利用机器学习算法识别重复数据

机器学习算法在识别重复数据方面有着独特的优势。通过训练模型,我们可以利用机器学习算法自动识别和筛选出重复数据。

10.建立数据质量管理系统

建立数据质量管理系统可以帮助我们全面管理和监控数据的质量,及时发现和处理重复数据,提高工作效率和数据准确性。

11.与团队成员共享经验和技巧

与团队成员共享经验和技巧是一个有效的学习和提升筛选重复数据能力的方式。通过交流和分享,我们可以学习到更多实用的方法和技巧。

12.建立数据备份和恢复机制

建立数据备份和恢复机制是应对数据重复问题的重要措施。通过定期备份数据,并建立有效的恢复机制,我们可以在发现重复数据时快速回滚到之前的版本。

13.不断优化筛选算法和规则

筛选重复数据是一个不断优化的过程。我们可以根据实际需求和经验不断优化筛选算法和规则,提高筛选效率和准确性。

14.密切关注数据质量和变化

密切关注数据质量和变化是防止数据重复的重要手段。我们应该定期检查和监控数据的质量和变化情况,并及时采取措施解决问题。

15.与展望

通过本文的介绍,我们了解了如何高效筛选重复数据的方法和技巧。合理利用这些方法和技巧,我们可以有效减少工作中的数据冗余与重复,提高工作效率和数据准确性。未来,随着技术的发展和应用的深入,筛选重复数据的能力将得到进一步提升,为我们的工作带来更多便利和效益。

结尾

本文介绍了如何高效筛选重复数据的方法和技巧,包括使用数据分析工具进行初步筛选、精确匹配、模糊匹配、建立索引和唯一标识、制定录入规范等。通过合理利用这些方法和技巧,我们可以有效减少工作中的数据冗余与重复,提高工作效率和数据准确性。同时,建议密切关注数据质量和变化,并不断优化筛选算法和规则,以应对日益复杂的数据环境。只有在有效筛选重复数据的基础上,我们才能更好地利用数据进行决策和创新,推动工作的高效进行。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

- 站长推荐

- 热门tag

- 标签列表

- 友情链接